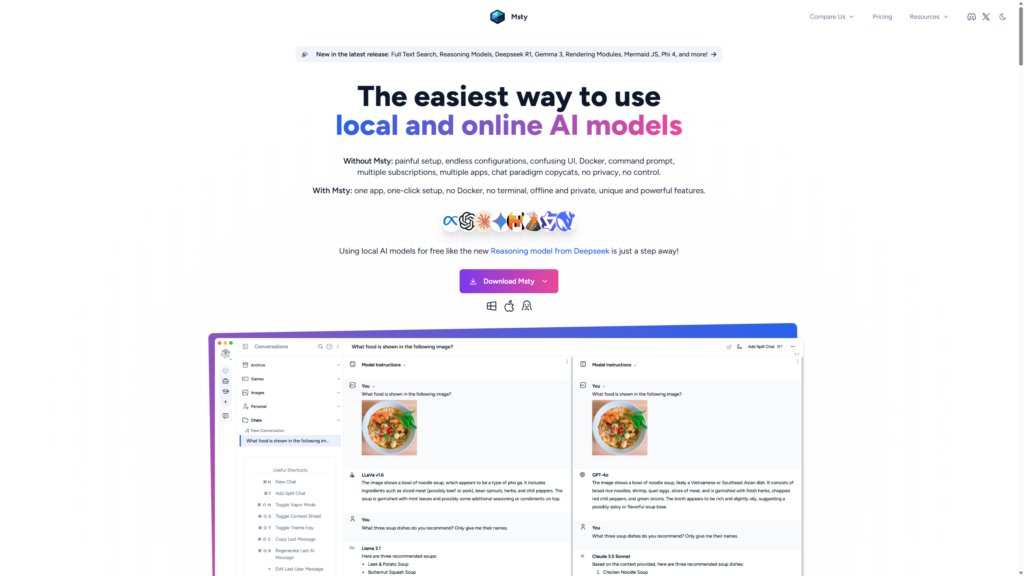

L’evoluzione dei modelli di intelligenza artificiale ha portato a un crescente interesse verso soluzioni locali, capaci di offrire autonomia e controllo nell’interazione con Large Language Models (LLM). In questo contesto, MSTY si presenta come un’applicazione multipiattaforma progettata per semplificare l’esecuzione di modelli open source, sia in locale che online, rappresentando un’opzione valida per sviluppatori e appassionati desiderosi di esplorare le potenzialità dell’IA senza la dipendenza da servizi cloud.

MSTY e i Suoi Vantaggi

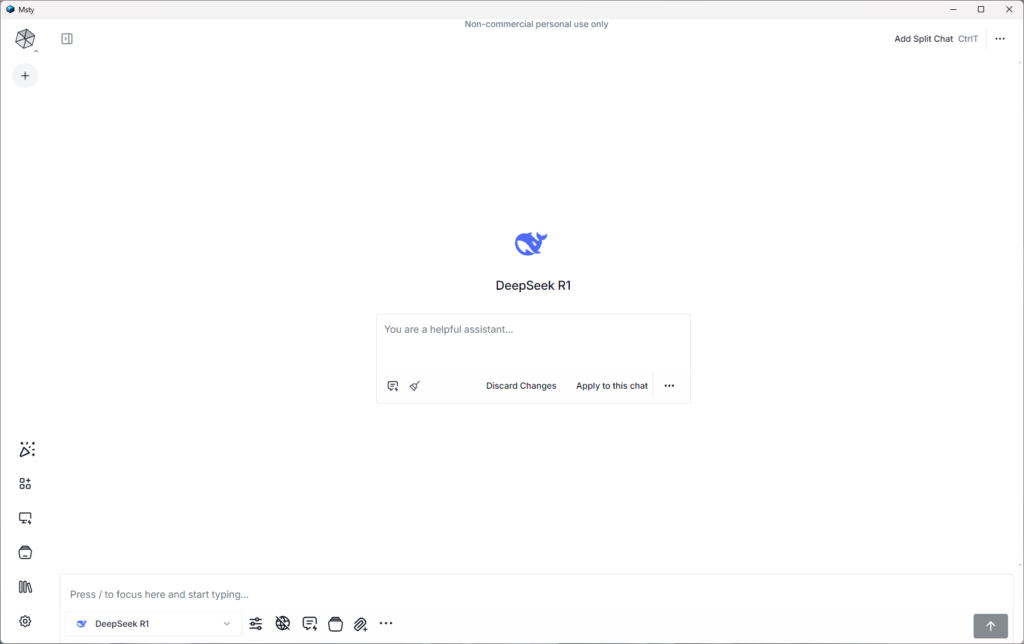

MSTY è un’applicazione compatibile con sistemi operativi Windows, Mac e Linux, concepita per facilitare l’utilizzo di modelli IA come Llama-2 e DeepSeek Coder. La sua interfaccia intuitiva permette una configurazione rapida, eliminando la necessità di complesse installazioni o l’utilizzo della riga di comando. Questa caratteristica la rende particolarmente adatta sia per chi si avvicina per la prima volta al mondo dell’IA locale, sia per utenti esperti alla ricerca di un ambiente di lavoro semplificato.

Uno dei principali punti di forza di MSTY risiede nella sua capacità di supportare sia LLM locali che online, offrendo agli utenti una notevole flessibilità. La piattaforma consente di passare agevolmente tra diversi modelli, tra cui Mixtral, Llama2, Qwen, GPT-3 e GPT-4, il tutto all’interno di un’unica interfaccia coesa.

La privacy e la possibilità di operare offline rappresentano ulteriori vantaggi significativi. L’esecuzione di modelli in locale garantisce che i dati sensibili rimangano confidenziali e accessibili anche in assenza di connessione internet, rispondendo alle crescenti preoccupazioni relative alla sicurezza e alla riservatezza dei dati.

MSTY si distingue anche per la sua interfaccia utente intuitiva, che semplifica il processo di interazione e perfezionamento dei testi generati dall’IA, rendendo la piattaforma accessibile a un’ampia gamma di utenti, indipendentemente dal loro livello di competenza tecnica.

Funzionalità Chiave per l’Utilizzo di LLM Locali

MSTY integra diverse funzionalità che ne accrescono l’utilità per l’esecuzione di LLM in locale. L’applicazione facilita il download dei modelli necessari e supporta l’accelerazione tramite GPU su MacOS, ottimizzando le prestazioni per gli utenti dotati di hardware compatibile. Per coloro che preferiscono l’utilizzo di modelli online, MSTY supporta l’integrazione di chiavi API, consentendo l’accesso a servizi basati su cloud quando necessario.

Una funzionalità di rilievo è il supporto per le pipeline di generazione aumentata dal recupero (RAG). Questa capacità permette di effettuare ricerche e recuperare informazioni da fonti esterne di conoscenza, migliorando la capacità del modello di fornire risposte accurate e pertinenti al contesto.

MSTY offre inoltre funzionalità avanzate come l’integrazione della ricerca web, chat suddivise e la “Modalità approfondimento” per un’analisi più dettagliata. La piattaforma include strumenti come Flowchat e Advanced Branching, utili per gestire conversazioni complesse e processi di pensiero in modo più efficace.

Per quanto riguarda la protezione della privacy, MSTY incorpora la funzionalità “Context Shield”, progettata per preservare la riservatezza dei dati durante le interazioni con l’IA. La “Modalità Vapor” fornisce un ulteriore livello di sicurezza per le conversazioni più sensibili.

Preparazione del Sistema per MSTY

Prima di procedere con l’installazione di MSTY LLM in locale, è fondamentale assicurarsi che il sistema soddisfi i requisiti necessari per un’installazione senza intoppi e prestazioni ottimali.

Per gli utenti Windows, è richiesto almeno Windows 10. L’applicazione necessita di un minimo di 8 GB di RAM, con 16 GB raccomandati per prestazioni superiori. È inoltre necessaria una CPU multi-core moderna per gestire le esigenze computazionali legate all’esecuzione di modelli IA locali.

Sebbene non indispensabile, una scheda grafica dedicata può migliorare significativamente le prestazioni. Su MacOS, MSTY supporta l’utilizzo della GPU, accelerando l’elaborazione per diverse attività di intelligenza artificiale.

È importante assicurarsi che sul sistema siano installati i driver più recenti, in particolare per gli utenti di GPU NVIDIA, per i quali è consigliabile installare i driver CUDA più recenti per abilitare l’accelerazione GPU.

Per ottimizzare le prestazioni, è consigliabile chiudere le applicazioni in background non necessarie. Per modelli più impegnativi, l’aggiornamento dell’hardware, in particolare la VRAM della GPU (consigliati 20-24+ GB per modelli con parametri da 70B), può essere preso in considerazione. Tuttavia, per modelli più piccoli (es. 9B), hardware meno potente può comunque fornire prestazioni soddisfacenti.

MSTY offre flessibilità nella scelta dei modelli, supportando sia modelli locali open source come Llama-2 e DeepSeek Coder, sia modelli online tramite chiavi API per servizi come OpenAI. La possibilità di operare offline garantisce privacy e sicurezza dei dati, rendendola ideale per l’elaborazione di informazioni sensibili o in ambienti con connettività limitata.

Guida all’Installazione Passo Passo di MSTY

Il processo di installazione di MSTY LLM in locale è semplice e diretto.

- Download della Versione Corretta: Visitare il sito web ufficiale di MSTY e scaricare la versione appropriata per il proprio sistema operativo (Windows, Mac o Linux), selezionando l’architettura corretta per gli utenti Windows (32 o 64 bit).

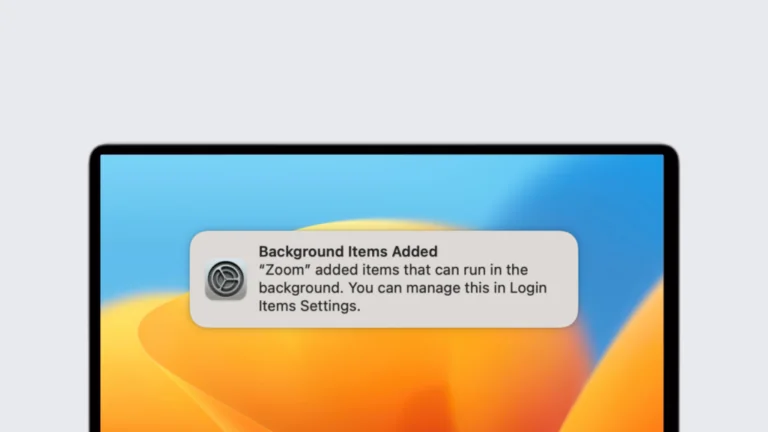

- Esecuzione del Programma di Installazione: Una volta scaricato il file, eseguirlo (fare doppio clic su Windows) per avviare la procedura guidata di installazione. Su Windows, potrebbe comparire un avviso di Windows Defender, che può essere tranquillamente ignorato. Seguire le istruzioni a schermo per completare l’installazione.

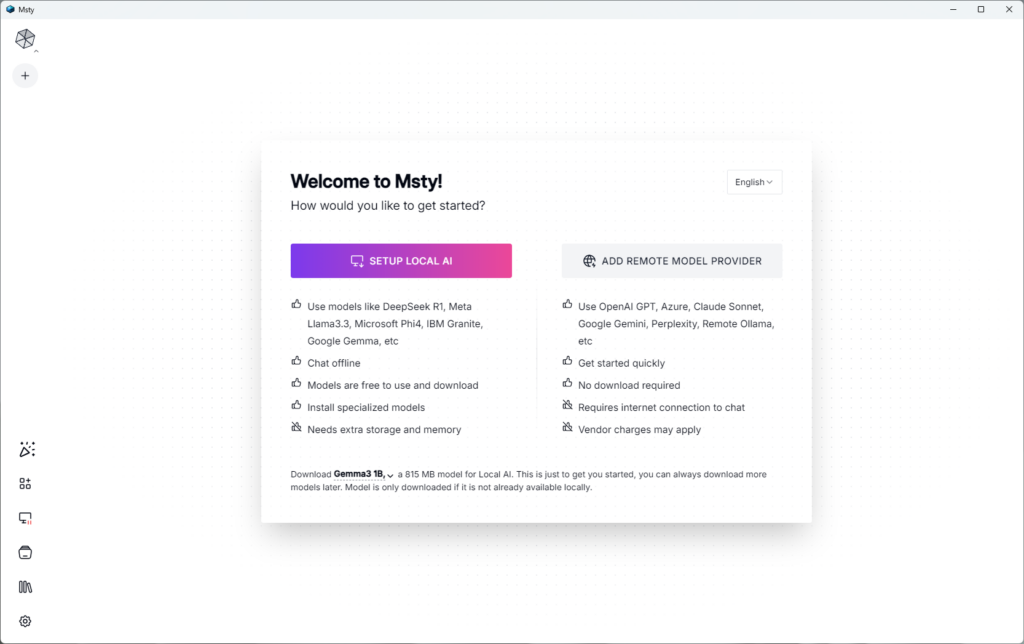

- Configurazione Post-Installazione: Al termine dell’installazione, avviare MSTY. Verranno presentate due opzioni: “IMPOSTA AI LOCALE” o “AGGIUNGI FORNITORE DI MODELLI REMOTI”. Per iniziare con i modelli IA locali, selezionare “SETUP LOCAL AI”. Questo avvierà automaticamente il download e l’installazione dei modelli necessari, inclusi tokenizzatori e impostazioni GPU, senza richiedere interventi da riga di comando.

Dopo la configurazione, potrebbe essere necessario riavviare l’applicazione. Una volta riaperta, è possibile iniziare a esplorare le funzionalità di MSTY, inclusa la chat offline con modelli IA, garantendo privacy e sicurezza dei dati.

MSTY offre anche la possibilità di aggiungere file (PDF, CSV, JSON) per creare una knowledge base personalizzata e supporta l’integrazione di link YouTube per estrarre trascrizioni e interagire con i contenuti video. L’applicazione fornisce un’interfaccia intuitiva per scaricare e gestire diversi modelli IA, indicando la compatibilità con l’hardware dell’utente.

Configurazione e Utilizzo di LLM Locali in MSTY

MSTY semplifica l’accesso e l’utilizzo dei modelli IA locali tramite la sezione “AI locale” nel menu dell’applicazione. Qui è disponibile un elenco di modelli scaricabili, con Llama 3 e Lava (per funzionalità multimodali) come opzioni consigliate. La scelta del modello dipende dai requisiti specifici del progetto e dalle risorse computazionali disponibili.

Una delle funzionalità distintive è il supporto per le pipeline RAG, che permettono di creare “stack di conoscenza”. Per impostare uno stack, fare clic su “Aggiungi il tuo primo stack di conoscenze” e selezionare un modello di incorporamento (Snowflake Arctic Embed è attualmente raccomandato). È possibile aggiungere diversi tipi di file (PDF, CSV, JSON) e integrare link YouTube per creare una base di conoscenza ricca e contestualmente rilevante.

Una volta configurati il LLM locale e gli stack di conoscenza, è possibile interagire con il modello AI tramite l’interfaccia di chat intuitiva di MSTY. L’applicazione offre funzionalità come chat divise e la possibilità di allegare stack di conoscenze specifici alle conversazioni.

Per chi desidera utilizzare anche modelli online, MSTY permette di aggiungere chiavi API per servizi come OpenAI, Gemini e Anthropic, offrendo flessibilità nella scelta del modello in base alle esigenze e ai requisiti di privacy.

L’interfaccia include anche funzionalità avanzate come “Delve Mode” e “Context Shield” per un’esperienza IA più sicura e personalizzabile.